Supongamos que tenemos que evaluar la usabilidad de los campos de una tabla para generar un documento de propuesta de atributos para una dimensión. ¿De que forma sabríamos si realmente sería un atributo útil?

Existen mil y un motivos para que los datos no sean los que esperemos, o lo que la organización espera. La calidad final de la información puede verse devaluada por inconsistencias en los contenidos.

¿Y por qué se degrada la calidad de los datos?

- Deficiencias en las validaciones de datos algunos sistemas (ERP, etc.)

- No se realizan chequeos contra datos maestros

- Los usuarios introducen cualquier cosa

- Etc.

Esta tarea genera las siguientes métricas sobre los datos:

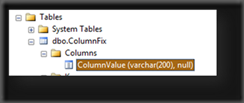

- Ratio de valores nulos por columna

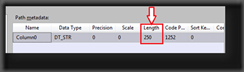

- Distribución de longitud de la columna, disponible para las columnas de tipo char, vachar, nchar, nvarchar.

- Perfilado de patrón de expresión, devuelve patrones de expresiones regulares que sigue un porcentaje especifico de filas.

- Perfil de estadísticas, para los tipos numéricos y fecha. Devuelve datos como el mínimo y máximo, medio y desviación para las columnas de tipo numérico.

- Distribución de valores, que devuelve todos los valores distintos junto con el porcentaje que representa cada valor en el conjunto.

- Claves candidatas. Detecta que columnas son candidatas a ser clave de la tabla por su unicidad en el conjunto.

- Grado de dependencia funcional, proporciona un ratio con el grado de dependencia de una columna sobre otra.

- Inclusión de valores,

Configurando Data Profiling Task

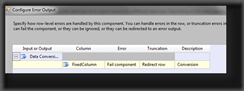

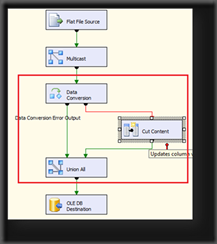

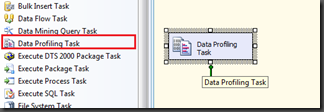

Creamos un nuevo paquete y añadimos el componente Data Profiling Task al flujo de control. Accedemos a la configuración y disponemos de tres secciones General, Profile Request (Solicitud de perfilado) y Expression.

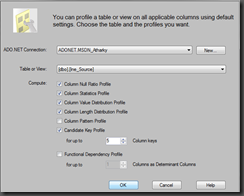

En la sección general configuramos el fichero XML dónde volcará los datos. En esta sección aparece el botón Quick Profile o Perfil Rápido

Configuramos una conexión ADO.NET y seleccionamos la tabla o vista sobre la que se requiera la solicitud de perfilados. Posteriormente seleccionamos los tipos de perfilado que deseemos generar.

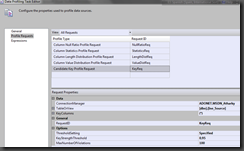

Si accedemos a la sección de configuración de Solicitud de Perfiles podremos revisar las solicitudes que hemos generado con el asistente.

Para optimizar la configuración de las solicitudes de perfiles, revisa la documentación de la MSDN http://msdn.microsoft.com/es-es/library/bb934043(v=SQL.100).aspx

La velocidad de ejecución de la tarea dependerá de la cantidad de datos existentes en la fuente, el número de solicitudes y la configuración de los perfilados que haya seleccionado.

Una vez generado el archivo XML podremos analizar los resultados con la herramienta Data Profile Viewer.

Recuerda que los archivos generados son XML y que pueden incorporarse a bases de datos fácilmente utilizando SSIS. ¿Te imaginas tener informes e indicadores en tu solución de BI que te informe sobre la variación de la calidad de los datos?

Pues a trabajar!

Microsoft tiene un video didáctico sobre el uso de estas herramientas: http://msdn.microsoft.com/en-us/library/cc952923(SQL.100).aspx

** Actualización

Navengando un poco he encontrado esta página http://informationqualitysolutions.com/page2/page10/page10.html

Un saludo!